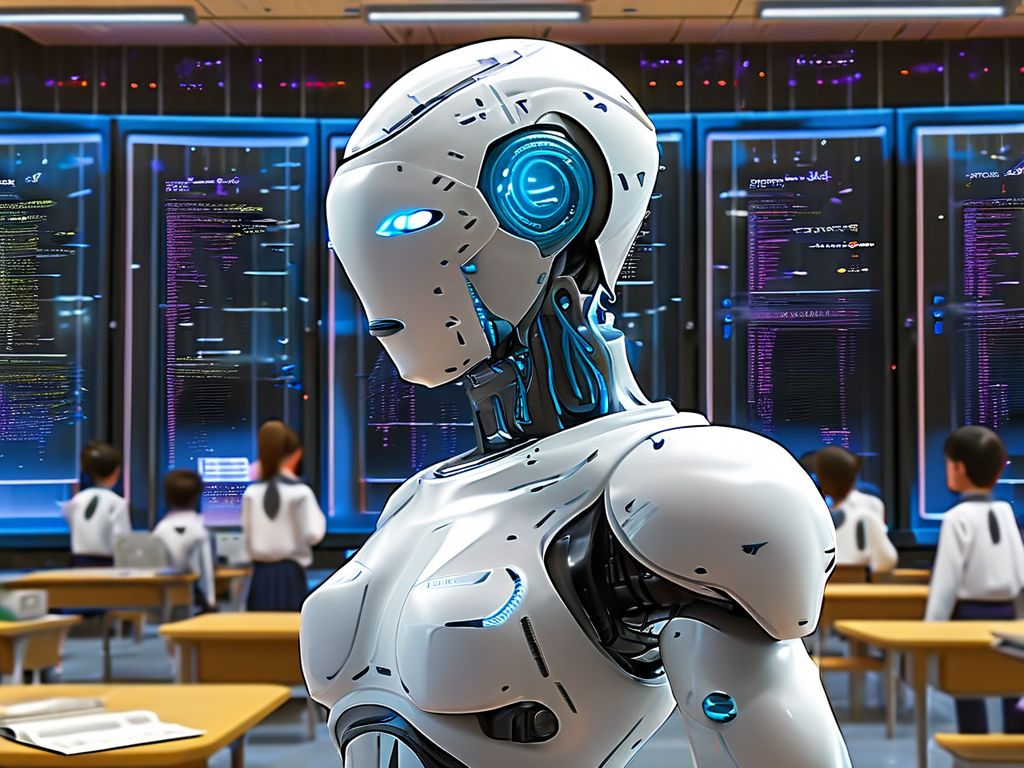

当你用ChatGPT聊职场技巧、让Stable Diffusion画出“赛博朋克猫”时,这些AI的“聪明才智”并非天生——它们是在“训练服务器”这个“超级教室”里,通过海量数据“学”出来的。

训练服务器,可不是普通的办公电脑或网站服务器,它是AI模型的“专属教练”。AI模型就像一张空白的试卷,要掌握语言理解、图像识别这些技能,得靠训练服务器喂给它数十亿甚至万亿级的“练习题”(也就是数据),再通过复杂的算法,反复调整模型里的“答题思路”(参数)。比如训练一个能识别肺癌的AI,服务器要带着模型“看”完数百万张肺部CT影像,让它从模糊的阴影里,学会分辨正常组织和病灶。

和普通服务器相比,训练服务器是“算力怪物”:它通常搭载多块高端GPU(比如NVIDIA H100),甚至几十上百块GPU组成集群——因为AI训练需要同时进行无数次矩阵运算,就像成千上万道数学题同时算,普通服务器根本扛不住。此外,它还得有高速内存和存储,确保数据像“快递”一样快速送到GPU手里,不耽误运算节奏。

你可能没见过训练服务器的真身,但它的“学生”早已渗透生活:手机里的智能相册分类、电商平台的个性化推荐、医院里的AI辅助诊断,背后都有训练服务器的功劳。比如阿里的“飞天”云服务器集群,就支撑着淘宝推荐算法、高德地图导航模型的训练;而OpenAI训练GPT-4时,更是动用了由数千块GPU组成的超级训练服务器集群,连续运算数月才让模型“毕业”。

有意思的是,训练服务器也是个“耗电大户”——训练一次GPT-3这样的大模型,电力消耗相当于一个普通家庭几十年的用电量。因此,很多科技公司会把训练服务器放在靠近水电站、风电场的机房,用清洁能源降低成本和碳排放。

说到底,训练服务器是AI技术的“幕后引擎”:没有它,再精妙的算法也只是空中楼阁,再海量的数据也无法变成AI的能力。正是这些默默运转的“超级教师”,让智能世界的边界不断拓展。