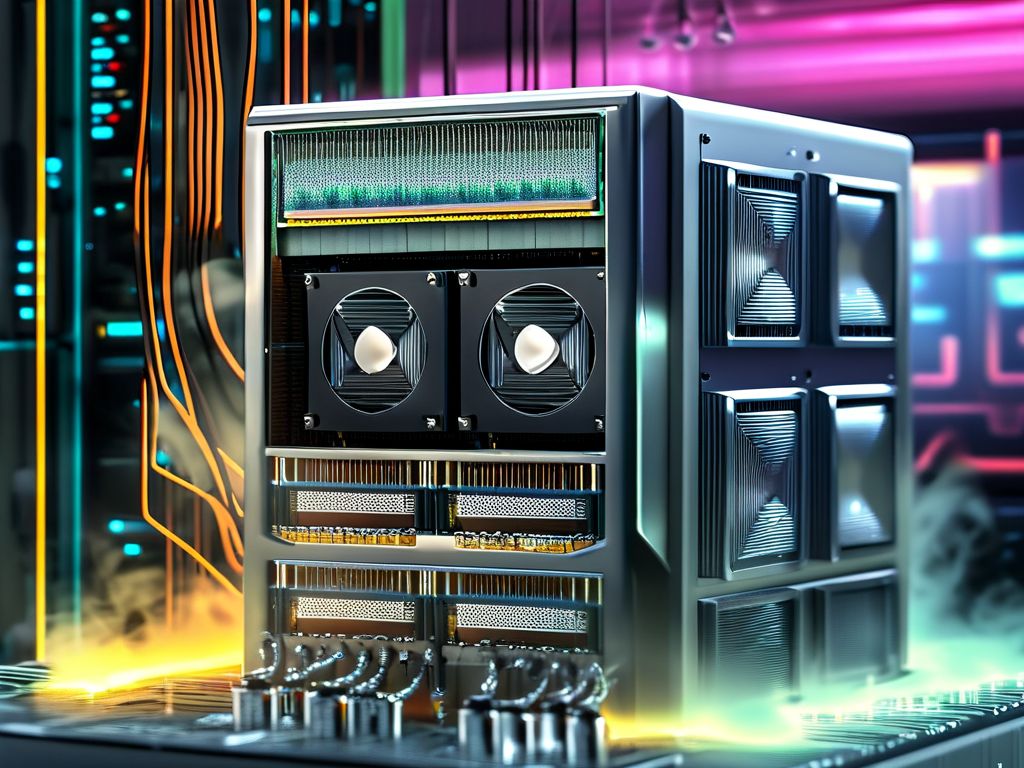

走进任何一个现代化数据中心,你都会看到密密麻麻的服务器机架——但如今,这些“数字引擎”的冷却方式正在悄然改变:越来越多的机架旁开始出现水管,“液冷”正取代传统风冷,成为高性能服务器的“降温新宠”。服务器芯片为什么非要“喝凉水”?答案藏在数字经济的增长密码里。

随着AI大模型、云计算的爆发,服务器芯片的性能正在以几何级速度飙升。以支撑ChatGPT的高端GPU为例,单颗芯片的功耗能轻松突破300瓦,甚至达到500瓦以上——相当于一盏大功率电灯泡持续发光,而芯片的核心温度一旦超过85℃,不仅会自动降频卡顿,长期高温还会缩短使用寿命,甚至直接烧毁。

传统的风冷散热早已捉襟见肘:风扇高速运转带来的噪音堪比工厂车间,同时风扇本身的能耗会推高数据中心的PUE(总能耗与IT设备能耗的比值,越接近1越节能);更关键的是,当服务器密度提升时,风冷无法快速带走密集芯片的热量,容易形成“热点”,制约算力输出。

液冷的核心优势在于“高效导热”——水的导热系数是空气的25倍以上,无论是将冷却液通过管道送到芯片附近的“冷板式液冷”,还是直接让液体浸泡芯片的“浸没式液冷”,都能比风冷更快带走热量。而且液冷系统可以减少甚至取消风扇,不仅降低了噪音污染,还能将PUE降至1.1以下(风冷数据中心的PUE通常在1.2~1.5之间),每年为一个中型数据中心节省数百万度电。

对于AI大模型训练这类“算力饥渴”的场景,液冷更是刚需。比如某头部科技公司的AI超算集群,每台服务器搭载8张高功耗GPU,若用风冷,机房温度可能飙升到40℃以上,芯片只能降频运行;而采用浸没式液冷后,芯片核心温度能稳定在50℃左右,满负荷运转时的算力输出提升了20%以上。

从“吹风”到“流水”,液冷的普及本质上是算力需求爆发的必然结果。当数字经济的齿轮越转越快,服务器芯片需要更高效、更节能的“降温搭档”——液冷,正是这场算力革命的“冷却剂”。